*Total -- 6,985.44kb -> 4,501.25kb (35.56%) /python/sensevoice/app/iic/SenseVoiceSmall/fig/inference.png -- 935.23kb -> 292.81kb (68.69%) /python/sensevoice/app/iic/SenseVoiceSmall/fig/asr_results.png -- 238.19kb -> 76.62kb (67.83%) /python/sensevoice/app/iic/SenseVoiceSmall/fig/sensevoice.png -- 879.78kb -> 332.45kb (62.21%) /python/sensevoice/app/iic/SenseVoiceSmall/fig/ser_table.png -- 318.12kb -> 145.67kb (54.21%) /docSite/assets/imgs/wechat6.png -- 208.98kb -> 119.19kb (42.97%) /docSite/assets/imgs/collection-tags-2.png -- 83.02kb -> 52.57kb (36.67%) /.github/imgs/intro3.png -- 258.74kb -> 167.94kb (35.09%) /python/sensevoice/app/iic/speech_fsmn_vad_zh-cn-16k-common-pytorch/fig/struct.png -- 27.26kb -> 17.81kb (34.66%) /.github/imgs/intro1.png -- 259.12kb -> 173.33kb (33.11%) /docSite/assets/imgs/fileinpu-2.png -- 214.61kb -> 147.20kb (31.41%) /.github/imgs/intro4.png -- 227.64kb -> 158.71kb (30.28%) /docSite/assets/imgs/questionGuide.png -- 38.89kb -> 27.95kb (28.13%) /python/sensevoice/app/iic/SenseVoiceSmall/fig/aed_figure.png -- 115.93kb -> 85.46kb (26.28%) /.github/imgs/intro2.png -- 370.64kb -> 273.45kb (26.22%) /docSite/assets/imgs/offiaccount-9.png -- 38.62kb -> 28.89kb (25.18%) /docSite/assets/imgs/collection-tags-3.png -- 125.71kb -> 98.27kb (21.83%) /docSite/assets/imgs/offiaccount-3.png -- 90.57kb -> 71.85kb (20.66%) /docSite/assets/imgs/feishu-bot-4.png -- 85.73kb -> 68.44kb (20.17%) /docSite/assets/imgs/feishu-bot-2.png -- 92.49kb -> 73.94kb (20.05%) /docSite/assets/imgs/offiaccount-1.png -- 99.70kb -> 79.77kb (19.98%) /docSite/assets/imgs/feishu-bot-1.png -- 154.50kb -> 126.89kb (17.87%) /docSite/assets/imgs/feishu-bot-6.png -- 160.72kb -> 133.59kb (16.88%) /docSite/assets/imgs/fileinpu-6.jpg -- 179.04kb -> 150.60kb (15.88%) /docSite/assets/imgs/feishu-bot-8.png -- 43.64kb -> 36.83kb (15.61%) /docSite/assets/imgs/offiaccount-7.png -- 73.88kb -> 62.58kb (15.29%) /python/sensevoice/app/iic/SenseVoiceSmall/fig/ser_figure.png -- 194.25kb -> 167.12kb (13.97%) /docSite/assets/imgs/feishu-bot-5.png -- 169.50kb -> 146.65kb (13.48%) /docSite/assets/imgs/offiaccount-8.png -- 129.99kb -> 114.37kb (12.02%) /docSite/assets/imgs/offiaccount-6.png -- 131.04kb -> 115.30kb (12.01%) /docSite/assets/imgs/feishu-bot-3.png -- 165.20kb -> 145.86kb (11.71%) /docSite/assets/imgs/offiaccount-4.png -- 158.75kb -> 140.69kb (11.38%) /docSite/assets/imgs/feishu-bot-7.png -- 95.10kb -> 84.29kb (11.37%) /docSite/assets/imgs/offiaccount-5.png -- 158.34kb -> 140.59kb (11.21%) /docSite/assets/imgs/offiaccount-2.png -- 163.30kb -> 145.59kb (10.84%) /docSite/assets/imgs/gpt-translate-example.png -- 299.24kb -> 297.98kb (0.42%) Signed-off-by: ImgBotApp <ImgBotHelp@gmail.com> Co-authored-by: ImgBotApp <ImgBotHelp@gmail.com>

frameworks, license, tasks

| frameworks | license | tasks | ||

|---|---|---|---|---|

|

Apache License 2.0 |

|

Highlights

SenseVoice专注于高精度多语言语音识别、情感辨识和音频事件检测

- 多语言识别: 采用超过40万小时数据训练,支持超过50种语言,识别效果上优于Whisper模型。

- 富文本识别:

- 具备优秀的情感识别,能够在测试数据上达到和超过目前最佳情感识别模型的效果。

- 支持声音事件检测能力,支持音乐、掌声、笑声、哭声、咳嗽、喷嚏等多种常见人机交互事件进行检测。

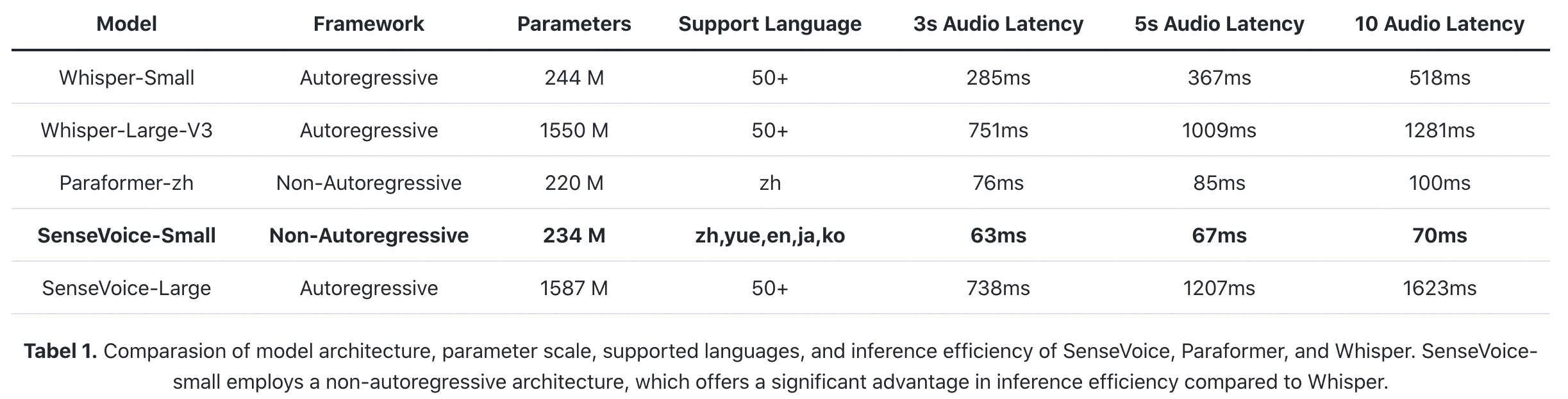

- 高效推理: SenseVoice-Small模型采用非自回归端到端框架,推理延迟极低,10s音频推理仅耗时70ms,15倍优于Whisper-Large。

- 微调定制: 具备便捷的微调脚本与策略,方便用户根据业务场景修复长尾样本问题。

- 服务部署: 具有完整的服务部署链路,支持多并发请求,支持客户端语言有,python、c++、html、java与c#等。

SenseVoice开源项目介绍

SenseVoice开源模型是多语言音频理解模型,具有包括语音识别、语种识别、语音情感识别,声学事件检测能力。

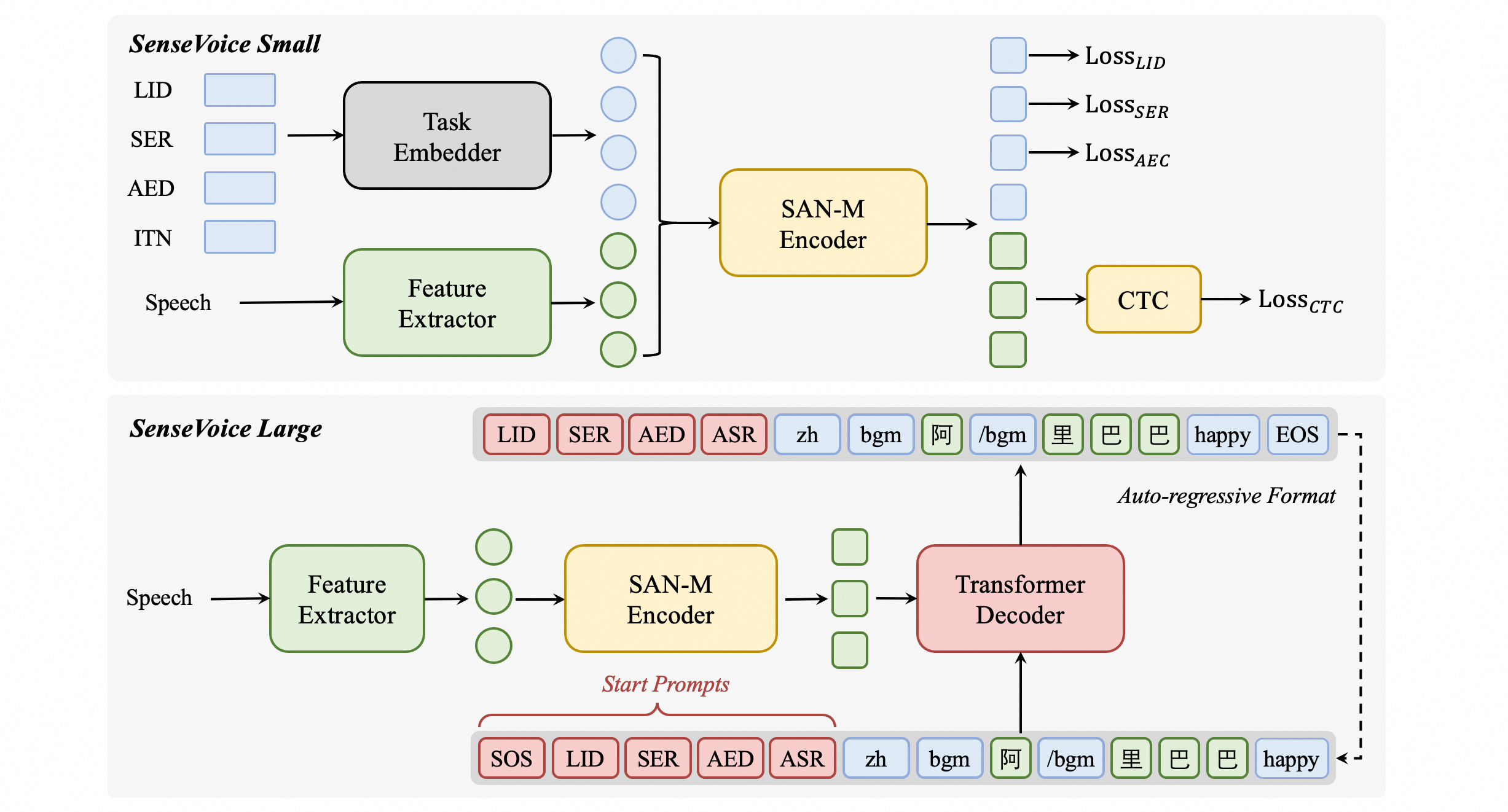

模型结构图

SenseVoice多语言音频理解模型,支持语音识别、语种识别、语音情感识别、声学事件检测、逆文本正则化等能力,采用工业级数十万小时的标注音频进行模型训练,保证了模型的通用识别效果。模型可以被应用于中文、粤语、英语、日语、韩语音频识别,并输出带有情感和事件的富文本转写结果。

SenseVoice-Small是基于非自回归端到端框架模型,为了指定任务,我们在语音特征前添加四个嵌入作为输入传递给编码器:

- LID:用于预测音频语种标签。

- SER:用于预测音频情感标签。

- AED:用于预测音频包含的事件标签。

- ITN:用于指定识别输出文本是否进行逆文本正则化。

用法

推理

modelscope pipeline推理

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

inference_pipeline = pipeline(

task=Tasks.auto_speech_recognition,

model='iic/SenseVoiceSmall',

model_revision="master")

rec_result = inference_pipeline('https://isv-data.oss-cn-hangzhou.aliyuncs.com/ics/MaaS/ASR/test_audio/asr_example_zh.wav')

print(rec_result)

直接推理

from model import SenseVoiceSmall

model_dir = "iic/SenseVoiceSmall"

m, kwargs = SenseVoiceSmall.from_pretrained(model=model_dir)

res = m.inference(

data_in="https://isv-data.oss-cn-hangzhou.aliyuncs.com/ics/MaaS/ASR/test_audio/asr_example_zh.wav",

language="auto", # "zn", "en", "yue", "ja", "ko", "nospeech"

use_itn=False,

**kwargs,

)

print(res)

使用funasr推理

from funasr import AutoModel

model_dir = "iic/SenseVoiceSmall"

input_file = (

"https://isv-data.oss-cn-hangzhou.aliyuncs.com/ics/MaaS/ASR/test_audio/asr_example_zh.wav"

)

model = AutoModel(model=model_dir,

vad_model="fsmn-vad",

vad_kwargs={"max_single_segment_time": 30000},

trust_remote_code=True, device="cuda:0")

res = model.generate(

input=input_file,

cache={},

language="auto", # "zn", "en", "yue", "ja", "ko", "nospeech"

use_itn=False,

batch_size_s=0,

)

print(res)

funasr版本已经集成了vad模型,支持任意时长音频输入,batch_size_s单位为秒。

如果输入均为短音频,并且需要批量化推理,为了加快推理效率,可以移除vad模型,并设置batch_size

model = AutoModel(model=model_dir, trust_remote_code=True, device="cuda:0")

res = model.generate(

input=input_file,

cache={},

language="auto", # "zn", "en", "yue", "ja", "ko", "nospeech"

use_itn=False,

batch_size=64,

)

更多详细用法,请参考 文档

模型下载

SDK下载

#安装ModelScope

pip install modelscope

#SDK模型下载

from modelscope import snapshot_download

model_dir = snapshot_download('iic/SenseVoiceSmall')

Git下载

#Git模型下载

git clone https://www.modelscope.cn/iic/SenseVoiceSmall.git

服务部署

Undo

Performance

语音识别效果

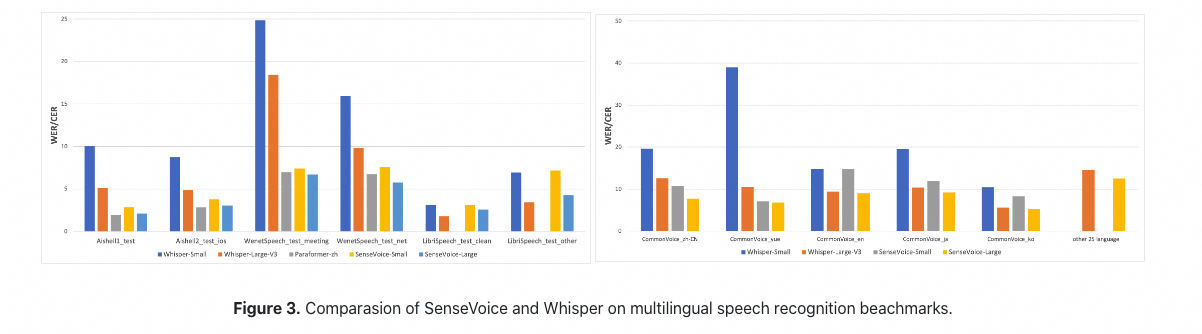

我们在开源基准数据集(包括 AISHELL-1、AISHELL-2、Wenetspeech、Librispeech和Common Voice)上比较了SenseVoice与Whisper的多语言语音识别性能和推理效率。在中文和粤语识别效果上,SenseVoice-Small模型具有明显的效果优势。

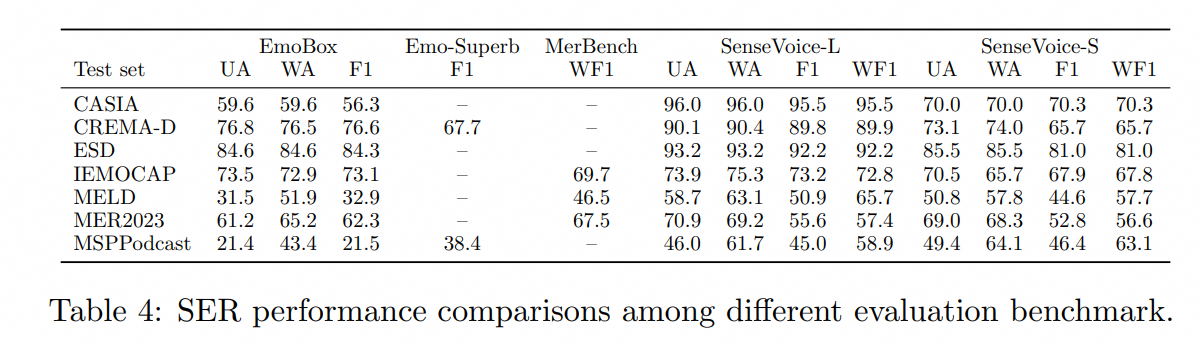

情感识别效果

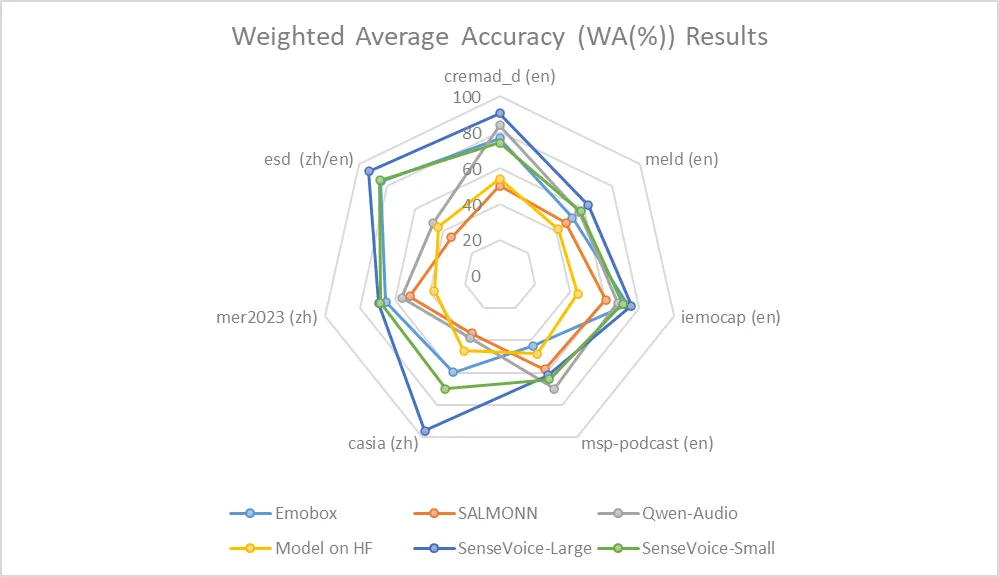

由于目前缺乏被广泛使用的情感识别测试指标和方法,我们在多个测试集的多种指标进行测试,并与近年来Benchmark上的多个结果进行了全面的对比。所选取的测试集同时包含中文/英文两种语言以及表演、影视剧、自然对话等多种风格的数据,在不进行目标数据微调的前提下,SenseVoice能够在测试数据上达到和超过目前最佳情感识别模型的效果。

同时,我们还在测试集上对多个开源情感识别模型进行对比,结果表明,SenseVoice-Large模型可以在几乎所有数据上都达到了最佳效果,而SenseVoice-Small模型同样可以在多数数据集上取得超越其他开源模型的效果。

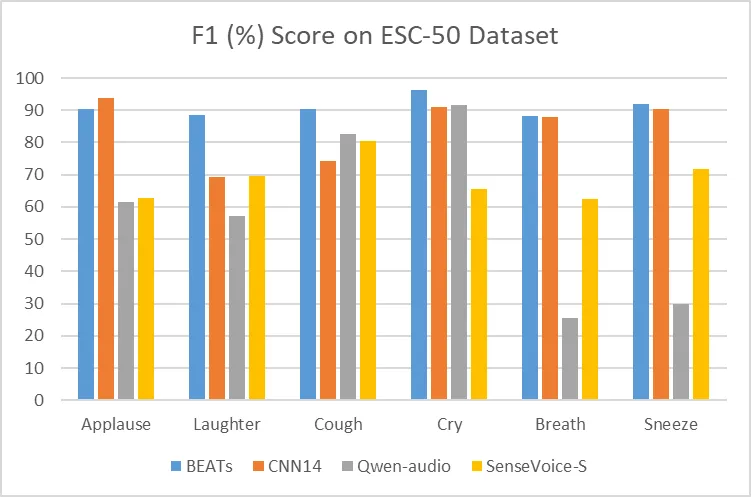

事件检测效果

尽管SenseVoice只在语音数据上进行训练,它仍然可以作为事件检测模型进行单独使用。我们在环境音分类ESC-50数据集上与目前业内广泛使用的BEATS与PANN模型的效果进行了对比。SenseVoice模型能够在这些任务上取得较好的效果,但受限于训练数据与训练方式,其事件分类效果专业的事件检测模型相比仍然有一定的差距。

推理效率

SenseVoice-Small模型采用非自回归端到端架构,推理延迟极低。在参数量与Whisper-Small模型相当的情况下,比Whisper-Small模型推理速度快7倍,比Whisper-Large模型快17倍。同时SenseVoice-small模型在音频时长增加的情况下,推理耗时也无明显增加。

如果您是本模型的贡献者,我们邀请您根据模型贡献文档,及时完善模型卡片内容。